Почему нужно снижать экзистенциальные риски

Table of Contents

- 1 Какова вероятность того, что вас убьет астероид? Обзор экзистенциальных угроз естественного происхождения

- 2 История прогресса, вплоть до начала самой опасной эпохи в истории человечества

- 3 История ядерного оружия: череда крайне опасных ситуаций

- 4 Насколько велики риски, связанные с изменением климата?

- 5 Какие новые технологии могут быть столь же опасными, как ядерное оружие?

- 6 Почему участие в защите будущего может быть самым важным делом вашей жизни

- 7 Почему эти риски являются одними из самых недооценённых глобальных проблем

- 8 Что можно сделать с этими рисками?

- 9 Кому не стоит фокусироваться на защите будущего?

- 10 Хотите поучаствовать в снижении экзистенциальных рисков?

- 11 Дальнейшее чтение

!podcast-player

В 1939 году Эйнштейн пишет Рузвельту:1

> Есть причины считать, что в большой массе урана возможен запуск цепной ядерной реакции... и можно предположить, хоть и с меньшей степенью уверенности, что это позволит создавать чрезвычайно мощные бомбы нового типа.

Всего через несколько лет эти бомбы были созданы. Спустя десять с небольшим лет их число достигло такого уровня, что впервые в истории маленькая группа людей, принимающих решения, могла полностью уничтожить цивилизацию.

Человечество вступило в новую эру. Теперь, помимо природных экзистенциальных рисков,2 мы встретились с риском самоуничтожения.

Предпочитаете подкаст?

После публикации этой статьи мы записали два подкаста на тему экзистенциальных рисков с доктором Тоби Ордом, философом из Оксфорда и доверенным лицом проекта "80 000 часов". Мы считаем, что они являются столь же хорошим введением в эту тему, как и данная статья, если не лучшим. Их можно послушать тут:

Предпочитаете книгу?

У Тоби Орда, философа из Оксфорда и консультанта проекта "80 000 часов", недавно вышла книга "На краю пропасти: Экзистенциальный риск и будущее человечества", в которой даётся обзор моральной значимости будущих поколений и того, что мы можем сделать сегодня, чтобы помочь им.

Мы вышлем вам книгу по почте (бесплатно)

Подпишитесь на рассылку "80 000 часов", и мы пришлём вам бесплатный экземпляр книги.

Также мы будем присылать свежую информацию о наших исследованиях, вакансии по работе над экзистенциальными рисками, и новости от автора.

Если вы уже подписаны на нашу рассылку, напишите нам на [email protected], чтобы получить экземпляр книги.

Учитывая этот новый контекст, что должно быть главным приоритетом нашей цивилизации? Совершенствование технологий? Помощь малоимущим слоям населения? Изменение политической системы?

Вот вариант, о котором говорят не так часто: нашим главным приоритетом должно быть выживание.

Пока цивилизация продолжает существовать, у нас есть шанс решить все остальные проблемы и прийти к гораздо лучшему будущему. Но если мы вымрем, то это будет конец.

Почему об этом мало говорят? Вот одна из причин: многие люди ещё не почувствовали, что мир значительно изменился, и поэтому не считают, что наше будущее находится под угрозой.

Исследователь в области социальных наук Спенсер Гринберг провел опрос среди американцев, чтобы узнать, как они оценивают шансы вымирания человечества в течение 50 лет. Результаты показали, что многие считают шансы крайне низкими: более 30% полагают, что они меньше, чем 1 на 10 миллионов.3

Сначала мы тоже считали, что подобные риски крайне малы, но, изучив этот вопрос, мы стали думать иначе. Далее мы увидим, что исследователи, изучающие эти вопросы, считают, что реальный риск вымирания в 1000+ раз выше оценки из опроса и скорее всего лишь продолжает расти.

Эти опасения положили начало новому движению по защите цивилизации, к которому присоединились Стивен Хокинг, Макс Тегмарк и новые институты, основанные исследователями из Кембриджа, Массачусетского технологического института, Оксфорда и других мест.

В остальной части этой статьи мы расскажем о самых больших рисках для цивилизации, в том числе о потенциально более серьёзных рисках, чем ядерная война или изменение климата. Затем мы приведём доводы в пользу того, что снижение этих рисков может быть самым важным делом вашей жизни, и объясним, что конкретно вы можете для этого сделать. Если вы захотите использовать свою карьеру для работы над этими проблемами, мы также можем предоставить вам индивидуальную поддержку.

Время чтения: 25 минут

Какова вероятность того, что вас убьет астероид? Обзор экзистенциальных угроз естественного происхождения

Шанс вымирания размером в 1 на 10 миллионов в ближайшие 50 лет — оценка, которую дают многие люди — не соответствует реальности. Природные экзистенциальные угрозы можно довольно точно оценить по историческим данным, и их шансы гораздо выше.

Столкновение Земли с километровым астероидом может привести к уничтожению цивилизации. На основе исторических данных и наблюдений за небесными телами, астрономы оценивают риск столкновения такого астероида с Землёй как 1 из 5000 в столетие.4 Это выше, чем шансы большинства людей попасть в авиакатастрофу (где-то 1 на 5 миллионов за рейс), и уже примерно в 1000 раз выше, чем шанс в 1 на 10 миллионов, который дали некоторые люди в качестве своей оценки.5

Некоторые утверждают, что хотя столкновение с километровым объектом было бы катастрофой, такого размера недостаточно, чтобы привести к вымиранию человечества, поэтому указанная оценка риска скорее всего завышена. Но с другой стороны, существуют и другие природные риски, такие как супервулканы.6

Тем не менее, естественные риски всё ещё довольно малы в абсолютных числах. В статье Тоби Орда, которая выйдет в ближайшее время, подсчитано, что если сложить все естественные риски вместе, то полученные шансы вымирания человечества вряд ли превысят 1/300 за столетие.7

К сожалению, как мы сейчас покажем, естественные риски ничтожны по сравнению с антропогенными. Именно поэтому риск вымирания стал особенно острой проблемой.

История прогресса, вплоть до начала самой опасной эпохи в истории человечества

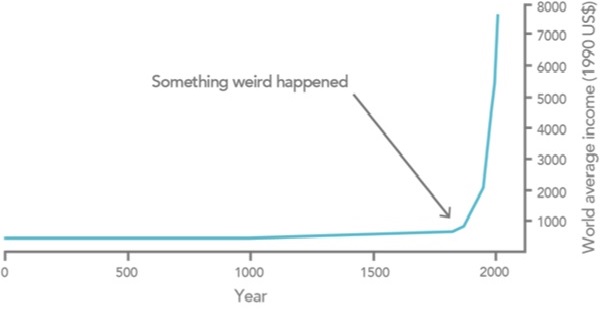

Если посмотреть на историю человечества в масштабе тысячелетий, то суть будет примерно такой: долгое время почти все были бедными, а затем, в 18-м веке, всё изменилось.8

Это было вызвано промышленной революцией — быть может, самым важным событием в истории.

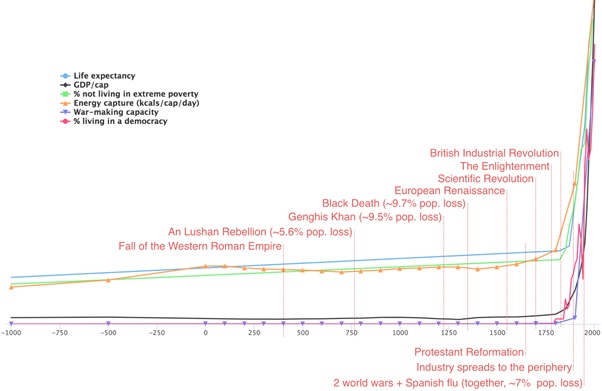

Росло не только богатство. Следующий график показывает, что в масштабе истории продолжительность жизни, энергопотребление и демократия быстро выросли, в то время как процент живущих в бедности резко сократился.9

График подготовлен Люком Мюльхаузером в 2017 году.

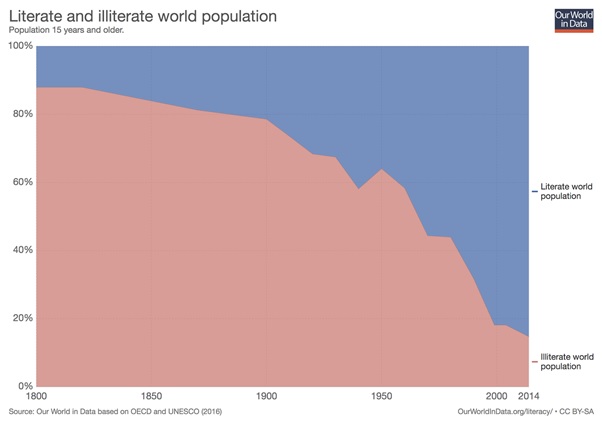

Уровни грамотности и образования также значительно выросли:

Насколько мы знаем, с повышением уровня богатства люди также становятся счастливее.

В книге "Лучшее в нас" Стивен Пинкер утверждает, что уровень насилия снижается.10 11

Личных свобод стало больше, в то время как расизма, сексизма и гомофобии стало меньше.

Многие люди считают, что мир становится хуже,12 и в этом есть своя правда — в современной цивилизации существуют ужасные вещи вроде промышленного животноводства. Но, как видно из приведённых данных, многие важные показатели прогресса значительно улучшились.

Так или иначе, что бы вы ни думали про прошлое, если смотреть в будущее, то улучшение технологий, политической организации, а также повышение свободы общества сможет дать нашим потомкам возможность решить наши текущие проблемы и жить намного лучше.13 Можно будет покончить с бедностью, предотвратить изменение климата, облегчить многие страдания — и этот список лишь продолжается.

Но обратите также внимание на фиолетовую линию на втором графике: военный потенциал. Эти данные были взяты из оценок глобальной военной мощи историка Иэна Морриса. Как видите, эта линия тоже резко стремится вверх.

Проблема заключается в следующем: развитие технологий может таить в себе как огромные выгоды, так и огромные риски.

Когда мы открываем новые технологии, в большинстве случаев они приносят огромную пользу. Но есть также шанс, что какая-нибудь новая технология будет обладать настолько высоким разрушительным потенциалом, что мы не сможем обеспечить достаточно безопасные условия для её использования.

И поэтому, хотя нынешнее поколение живет в самый благополучный период в истории человечества, он, возможно, также является самым опасным.

Первой разрушительной технологией такого рода стало ядерное оружие.

История ядерного оружия: череда крайне опасных ситуаций

Сегодня мы все думаем о ядерной программе Северной Кореи, но нынешние события — лишь одна глава в длинной истории крайне опасных ситуаций.

Только во время Кубинского ракетного кризиса мы несколько раз были близки к ядерной войне.14 В одном из случаев американцы решили, что если один из их самолетов-шпионов будет сбит, то они немедленно начнут вторжение на Кубу без дополнительного заседания Военного совета. На следующий день самолет-шпион был сбит. Кеннеди всё равно созвал совет и принял решение не вводить войска.

Вторжение на Кубу вполне могло привести к ядерной войне: позже выяснилось, что Кастро выступал за ядерный ответ, даже если "это привело бы к полному уничтожению Кубы". Некоторые из командиров пусковых установок на Кубе также имели независимые полномочия наносить удары по американским силам тактическим ядерным оружием в случае вторжения.

В другом инциденте российская атомная подводная лодка пыталась тайком провезти материалы на Кубу, когда её обнаружил американский флот. Флот начал сбрасывать фиктивные глубинные бомбы, чтобы заставить подводную лодку всплыть. Русский капитан подумал, что это настоящие глубинные бомбы и что, пока не было радиосвязи, началась третья мировая война. Он приказал нанести ядерный удар по американскому флоту одной из ядерных торпед.

К счастью, для такого приказа было необходимо согласие от других старших офицеров. Один их них, Василий Архипов, был против и таким образом предотвратил войну.

Спасибо вам, Василий Архипов.

Сопоставив все эти события вместе, Кеннеди позже говорил, что вероятность ядерной войны была "между 33-мя и 50-ю процентами".15

Подобных опасных столкновений с Россией было немало, даже после холодной войны: на Википедии есть релевантный список. И это лишь те, о которых нам известно.

Сегодня эксперты по ядерным вопросам обеспокоены напряжённостью между Индией и Пакистаном (обе страны обладают ядерным оружием) не меньше, чем Северной Кореей.16

Главная проблема заключается в том, что несколько стран располагают крупными ядерными арсеналами и могут применить их в считанные минуты. Это означает, что ложная тревога или иная ошибка может быстро перерасти в полномасштабную ядерную войну, особенно в период напряженных международных отношений.

Приведёт ли ядерная война к гибели цивилизации? Первоначально считалось, что ядерный взрыв может быть настолько горячим, что воспламенит атмосферу и сделает Землю непригодной для жизни. Но учёные посчитали, что вероятность такого исхода достаточно мала. Это позволило нам провести "безопасные" испытания ядерного оружия, и теперь мы знаем, что такого не случится.

В 1980-х годах люди опасались, что пепел от горящих зданий погрузит Землю в очень долгую зиму, которая сделает невозможным выращивание сельскохозяйственных культур в течение десятилетий.17 Современные климатические модели предполагают, что сильная ядерная зима, в результате которой все умрут, очень маловероятна (хотя из-за неопределённости моделей мы не можем полностью доверять этим оценкам.18 )

Однако даже "умеренная" ядерная зима всё равно может привести к массовому голоду.19 По этой и другим причинам ядерная война была бы чрезвычайно дестабилизирующей для мира, и неизвестно, сможет ли цивилизация восстановиться после неё.

Какова вероятность того, что ядерная война навсегда уничтожит цивилизацию? Это очень трудно оценить, но, скорее всего, вероятность такого события в ближайшие сто лет как минимум превышает 0,3%. Если это так, то риски от ядерного оружия будут выше, чем все природные риски, вместе взятые. (Подробнее о ядерных рисках.)

Вот почему 1950-е годы стали началом новой эры для человечества. Впервые в истории у маленькой группы людей, принимающих решения, появилась возможность разрушить весь мир. Теперь самой большой угрозой для собственного выживания являемся мы сами, и это делает наше время самым опасным в истории человечества.

И ядерное оружие — не единственный способ, при помощи которого мы можем уничтожить цивилизацию.

Насколько велики риски, связанные с изменением климата?

В 2015 году президент Обама заявил в своем обращении к Конгрессу, что "ни одна проблема не представляет столь большой угрозы для будущих поколений, как изменение климата".

Безусловно, изменение климата представляет собой серьёзный риск для цивилизации.

Наиболее вероятный результат — 2-4 градуса потепления.20 Это плохо, но такие изменения не ставят под угрозу выживание нашего вида.

Однако некоторые оценки дают 10% вероятность потепления свыше 6 градусов и примерно 1% шанс потепления на 9 градусов.

Таким образом, получается, что вероятность масштабной климатической катастрофы в результате выбросов CO2 примерно равна вероятности ядерной войны.

Но, как мы утверждаем в нашем обзоре проблемы изменения климата, даже потепление на 13 градусов вряд ли само по себе приведёт к вымиранию человечества. Поэтому исследователи, изучающие эти вопросы, считают, что ядерная война с большей вероятностью может привести к вымиранию напрямую (из-за возможности ядерной зимы), и поэтому мы считаем, что ядерное оружие представляет собой ещё более серьёзный риск, чем изменение климата.

Тем не менее, изменение климата является серьёзной проблемой, и его дестабилизирующие последствия могут усугубить другие риски, в том числе риск ядерного конфликта, что лишь повышает наши оценки рисков данной проблемы.

Какие новые технологии могут быть столь же опасными, как ядерное оружие?

Изобретение ядерного оружия привело к возникновению антиядерного движения всего десятилетие спустя, а вскоре после этого движение защитников окружающей среды взялось за борьбу с изменением климата.

Менее очевидный вывод заключается в том, что новые технологии будут создавать новые катастрофические риски. Поэтому нам необходимо движение, которое занимается защитой цивилизации в целом.

Предсказывать будущее технологий сложно, но поскольку цивилизация у нас всего одна, нам нужно делать всё, что в наших силах. Вот несколько кандидатов на роль следующей технологии, потенциально столь же опасной, как ядерное оружие.

В 1918-1919 годах от испанского гриппа умерло более 3% населения Земли.21 Если бы такая пандемия вспыхнула сегодня, то её было бы ещё труднее сдерживать из-за скоростного глобального транспорта.

Однако больше тревоги вызывает то, что скоро может появиться возможность генетически сконструировать вирус, который будет таким же заразным, как испанский грипп, но при этом более смертоносным, и который сможет годами распространяться незамеченным.

Это было бы оружие с разрушительной мощью ядерного, но чьё применение гораздо труднее предотвратить. Ядерное оружие требует огромных заводов и редких материалов для производства, что делает его относительно легким для контроля. Искусственные вирусы же можно потенциально создать в лаборатории с парой докторов биологических наук. Более того, в 2006 году The Guardian смогли заказать по почте сегменты вымершего вируса оспы.22 Некоторые террористические группировки уже заявляли о своём интересе к подобному оружию неизбирательного действия. (Подробнее о рисках пандемий.)

Кто заказывал оспу? Источник: The Guardian

Ещё одна новая технология с огромной потенциальной мощью — искусственный интеллект.

Причина, по которой на планете стали главными люди, а не шимпанзе, кроется исключительно в интеллекте. Размеры и мощь наших мозгов обеспечили нам поразительный контроль над миром, хотя физически мы намного слабее шимпанзе.

Что же произойдёт, если однажды мы создадим нечто гораздо более разумное, чем мы сами?

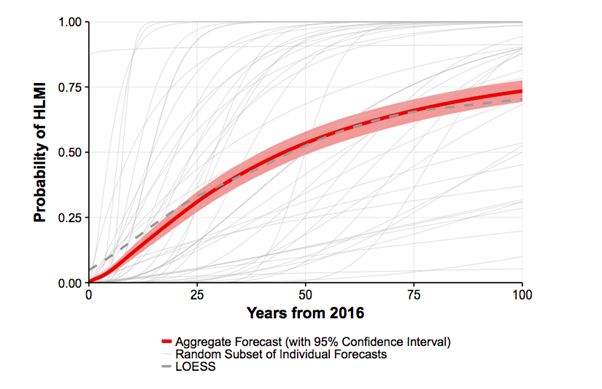

В 2017 году 350 исследователей, публиковавших свои рецензируемые статьи на тему ИИ на ведущих конференциях, были опрошены о том, когда, по их мнению, будет разработан компьютер с интеллектом человеческого уровня: то есть машина, способная выполнять все рабочие задачи лучше, чем человек.

Медианной оценкой была 50% вероятность того, что мы разработаем высокоуровневый машинный интеллект (ВМИ) в течение 45 лет, и 75% — что это произойдёт к концу века.23

Такие вероятности сложно оценивать, и исследователи давали очень разные ответы в зависимости от конкретных формулировок вопроса.24 Тем не менее, есть причины полагать, что существует как минимум существенная вероятность создания трансформационного машинного интеллекта в ближайшие сто лет. Более того, из высокой степени неопределённости следует, что это может случиться раньше, чем мы полагаем.

Какие риски может представлять такая технология? Первопроходцы в области вычислительной техники, такие как Алан Тьюринг и Марвин Мински, высказывали опасения по поводу рисков, связанных с мощными компьютерными системами,25 и эти риски до сих пор актуальны. Мы говорим не о "злых" компьютерах, а скорее о том, что мощная ИИ-система может быть использована какой-то группой людей для установления контроля над миром или как-то иначе задействована в плохих целях. Если бы СССР разработал ядерное оружие на 10 лет раньше, чем США, то СССР мог бы стать доминирующей мировой державой. Мощные компьютерные технологии могут представлять аналогичные риски.

Другая проблема заключается в том, что запуск такой системы может привести к непредвиденным последствиям, поскольку сложно предсказать действия чего-то более умного, чем мы сами. Достаточно мощной системой также может быть сложно управлять, и поэтому её запуск может оказаться труднообратимым. Подобные сценарии были описаны оксфордским профессором Ником Бостромом в книге "Искусственный интеллект" и пионером ИИ Стюартом Расселом.

Большинство экспертов считают, что развитие ИИ приведёт к чрезвычайно положительным результатам, но при этом также не забывают о рисках. В вышеупомянутом опросе эксперты в области ИИ оценили, что разработка высокоуровневого машинного интеллекта с 10% шансом может привести к "плохому исходу" и с 5% шансом к "чрезвычайно плохому исходу", такому как вымирание человечества.26 Причём нам, вероятно, следует ожидать излишней оптимистичности от этой группы людей, поскольку они зарабатывают на жизнь благодаря этой технологии.

Сопоставив все полученные оценки, мы получим, что при 75% шансе создания высокоуровневого машинного интеллекта в течение следующих ста лет, вероятность крупной катастрофы, связанной с ИИ, составляет 5% от этих 75%, то есть в итоге около 4%. (Подробнее о рисках, связанных с искусственным интеллектом.)

Люди выражали беспокойство и по поводу других новых технологий, таких как некоторые формы геоинженерии и атомного производства, но поскольку они вряд ли будут разработаны в ближайшее время, их в целом считают менее опасными по сравнению с технологиями, о которых мы говорили. Более длинный список экзистенциальных рисков можно посмотреть здесь.

Что вызывает больше беспокойств, так это риски, о которых мы ещё даже не знаем. Если бы вы спросили людей в 1900-м году, что представляет наибольшую угрозу для цивилизации, они вряд ли бы упомянули атомное оружие, генную инженерию или искусственный интеллект, потому что ничто из этого ещё не было изобретено. Вполне возможно, что мы находимся в аналогичной ситуации, если говорить о следующем веке. Грядущие "неизвестные неизвестные" могут представлять больше опасности, чем уже известные нам риски.

Каждый раз, когда мы открываем новую технологию, это немного похоже на ставку против одного числа в рулетке. В большинстве случаев мы выигрываем, и технология в целом имеет хорошие последствия. Но каждый раз есть небольшой шанс, что технология будет обладать настолько большим разрушительным потенциалом, что мы не сможем с ней совладать, и тогда мы потеряем всё.

У каждой новой технологии беспрецедентными являются и потенциал, и опасности.

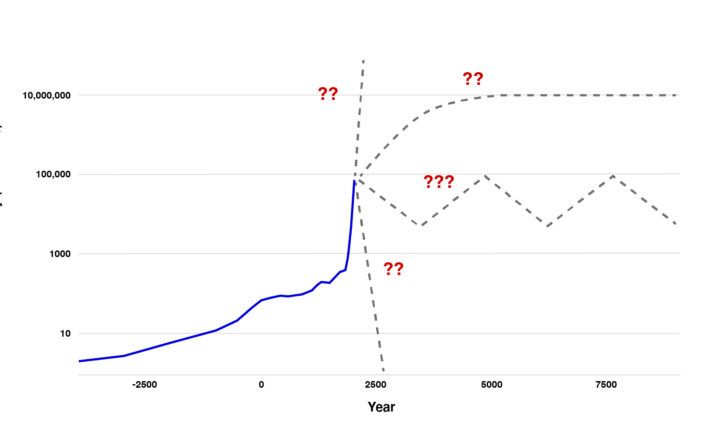

Каков суммарный риск вымирания человечества, если учесть все эти факторы?

По оценкам многих экспертов, изучающих эти вопросы, суммарная вероятность вымирания человечества в следующем столетии составляет от 1 до 20%.

Например, согласно неофициальному опросу, проведенному в 2008 году на конференции по катастрофическим рискам, эксперты сочли вполне вероятной катастрофу, в результате которой погибнет более миллиарда человек, а также оценили вероятность вымирания человечества до 2100 года в 19%.27

| Угроза | Минимум миллиард смертей | Вымирание человечества |

|---|---|---|

| Количество смертей от молекулярного нанооружия | 10% | 5% |

| Суммарное количество смертей из-за сильного ИИ | 5% | 5% |

| Суммарное количество смертей из-за всех войн (включая гражданские) | 30% | 4% |

| Количество смертей из-за самой большой искусственной пандемии | 10% | 2% |

| Суммарное количество смертей из-за всех атомных конфликтов | 10% | 1% |

| Количество смертей из-за самой большой нанотехнологической аварии | 1% | 0.5% |

| Количество смертей из-за самой большой естественной пандемии | 5% | 0.05% |

| Суммарное количество смертей из-за всех террористических актов с применением атомного оружия | 1% | 0.03% |

| Общий риск вымирания до 2100 года | n/a | 19% |

Эти цифры примерно в миллион раз превышают оценки большинства людей.

В нашем подкасте с Уиллом Макаскиллом мы обсуждаем, почему он оценивает риск вымирания в этом веке примерно в 1%.

В своей книге "На краю пропасти. Экзистенциальный риск и будущее человечества" Тоби Орд предполагает, что общий экзистенциальный риск в этом веке составляет 1/6, что равноценно броску игральной кости. Послушать наш подкаст с Тоби можно тут.

Какие выводы стоит делать из этих оценок? По всей видимости, исследователи работают над этими вопросами только лишь потому, что считают их очень важными, поэтому мы должны ожидать, что их оценки будут высокими (см. "систематическая ошибка отбора"). Но значит ли это, что мы можем полностью игнорировать их опасения?

С учётом всего этого, какова наша собственная оценка? Это очень сложный вопрос, но нам кажется, что нельзя с уверенностью игнорировать эти риски. В целом, мы полагаем, что общий риск, скорее всего, превышает 3%.

Почему участие в защите будущего может быть самым важным делом вашей жизни

Насколько приоритетной должна быть работа по снижению этих рисков по сравнению с другими вопросами, такими как глобальная бедность, борьба с раком или улучшение политической системы?

В рамках проекта "80 000 часов" мы проводим исследования, цель которых — помогать людям с поиском работы, которая приносит пользу обществу. Для этого мы стараемся находить наиболее актуальные проблемы в мире, над которыми необходимо работать. Мы оцениваем различные глобальные проблемы, используя нашу модель, которая сравнивает их по следующим критериям:

Масштаб — сколько людей затрагивает эта проблема

Недооценённость — сколько людей уже работают над ней

Разрешимость — насколько легко продвинуться в её решении

Мы считаем, что если придерживаться этой модели, то защита будущего становится самым главным приоритетом общества. Поэтому если вы хотите принести много пользы миру при помощи своей работы, в первую очередь стоит сфокусироваться на этой области.

В следующих нескольких разделах мы рассмотрим этот вопрос с точки зрения масштаба, недооценённости и разрешимости, в значительной степени опираясь на "Existential Risk Prevention as a Global Priority" Ника Бострома и неопубликованную работу Тоби Орда, а также на наши собственные исследования.

Давайте начнём с масштаба проблемы. Мы утверждали, что вероятность вымирания в следующем столетии составляет более 3%. Насколько это серьёзно?

В первую очередь посмотрим на количество людей, которые могут погибнуть в результате такой катастрофы. Население планеты в середине этого века будет составлять примерно 10 миллиардов человек, поэтому 3% шанс полного вымирания даёт математическое ожидание примерно в 300 миллионов смертей. Судя по всему, это больше смертей, чем можно ожидать за ближайшие сто лет от "болезней бедности" вроде малярии.28

Помимо гибели цивилизации, многие из рассмотренных нами рисков также могут привести к катастрофе "средней" тяжести, и это может быть намного более вероятным. Опрос, о котором мы говорили ранее, показал более 10% шанса катастрофы, из-за которой в следующем веке может погибнуть более 1 миллиарда людей. Это даёт нам математическое ожидание как минимум ещё в 100 миллионов смертей, а также намного больше страданий среди тех, кто выживет.

Таким образом, даже если мы сосредоточимся только на последствиях для ныне живущего поколения, то эти катастрофические риски являются одной из самых серьёзных проблем, стоящих перед человечеством.

Но в этом случае масштабы проблемы будут очень сильно недооценены, потому что если нашей цивилизации придёт конец, то мы полностью потеряем и наше будущее.

Большинство людей хотят оставить лучший мир для своих внуков, и многие также считают, что нам нужно в какой-то мере заботиться и о будущих поколениях в целом. В будущем может быть намного больше людей, довольных своей жизнью, чем всех людей, живущих сейчас, и нам нужно в какой-то степени учитывать их интересы. Есть шанс, что человеческая цивилизация просуществует миллионы лет, поэтому если учитывать последствия рисков для всех будущих поколений, то ставки увеличиваются в миллионы раз — как для хороших исходов, так и для плохих. Карл Саган писал о цене ядерной войны в журнале Foreign Affairs:

> Ядерная война ставит под угрозу жизни всех наших потомков на протяжении всего времени потенциального существования человечества. Даже если наше население перестанет расти, а средняя продолжительность жизни будет порядка 100 лет, то в условиях типичного периода времени, необходимого для цикла биологической эволюции успешного вида (примерно 10 миллионов лет), речь идёт о 500 триллионах человек, которые ещё не родились. С учётом этого, исход полного вымирания будет в миллион раз хуже, чем более скромные ядерные войны, которые убивают "всего лишь" сотни миллионов людей. Есть также много других возможных способов измерять потенциальные потери, включая культуру и науку, эволюционную историю планеты и значимость жизней всех наших предков, сделавших вклад в будущее своих потомков. Вымирание сотрёт всё, что построило человечество.

Мы рады, что римляне не позволили человечеству исчезнуть, ведь благодаря этому существует вся современная цивилизация. Мы считаем, что на нас лежит аналогичная ответственность за людей будущего, если предполагать, что их жизни скорее будут хорошими (а мы думаем, что будут). Было бы необдуманно и несправедливо подвергать их жизни опасности лишь для того, чтобы сделать себе получше в краткосрочной перспективе.

Дело не только в том, что в будущем может быть больше людей. Как отмечал и Саган, вне зависимости от того, что именно вы цените, в будущем этого может быть гораздо больше. Цивилизация будущего может построить мир без нужды, добиться потрясающих интеллектуальных успехов или создать величайшие произведения искусства. Мы можем построить намного более справедливое и нравственное общество. И в принципе ничто не мешает нашей цивилизации достичь других планет, которых в нашей галактике около 100 миллиардов.29 Если мы позволим человечеству погибнуть, то все эти возможности будут навсегда перечёркнуты.

Мы не уверены, что это замечательное будущее действительно наступит, но это лишь ещё одна причина сохранить цивилизацию: ведь тогда у нас будет шанс узнать, как всё обернётся. Пожалуй, худшее, что мы можем сделать — это не передать эстафету следующему поколению.

Таким образом, пара процентов риска уничтожения цивилизации — это, по всей видимости, самая серьёзная проблема человечества на данный момент. Поражает также то, насколько этими рисками пренебрегают.

Почему эти риски являются одними из самых недооценённых глобальных проблем

Вот сколько денег ежегодно тратится на некоторые из важных целей:30

| Цель | Ежегодные целевые расходы из всех источников (очень приблизительно) |

|---|---|

| Глобальные исследования и разработки | $1.5 триллиона |

| Предметы роскоши | $1.3 триллиона |

| Социальное обеспечение в США | $900 миллиардов |

| Изменение климата | >$300 миллиардов |

| Помощь бедным слоям населения мира | >$250 миллиардов |

| Ядерная безопасность | $1-10 миллиардов |

| Предотвращение экстремальных пандемий | $1 миллиард |

| Исследования в области безопасности ИИ | $10 миллионов |

Как видите, мы тратим огромное количество ресурсов на разработку ещё более мощных технологий. Мы также тратим много средств на предметы роскоши в попытке улучшить свои жизни (что, быть может, не так уж и хорошо работает).

На снижение катастрофических рисков, связанных с изменением климата, тратится гораздо меньше средств. Только лишь в США расходы на социальное обеспечение в разы превышают расходы на борьбу с изменением климата во всём мире.

Но на проблему изменения климата всё равно выделяются огромные суммы денег по сравнению с некоторыми другими рисками, о которых мы говорили. По нашим приблизительным оценкам, на предотвращение экстремальных глобальных пандемий тратится в 300 раз меньше средств, хотя масштаб риска выглядит примерно таким же.

Исследованиям в области безопасности ИИ уделяется меньше всего внимания, и на них выделяется ещё примерно в 100 раз меньше средств, чем на предотвращение пандемий: около 10 миллионов долларов в год.

Аналогичную картину можно увидеть, если вместо выделенных денег посмотреть на количество людей, работающих над этими рисками, но для денег проще получить цифры.

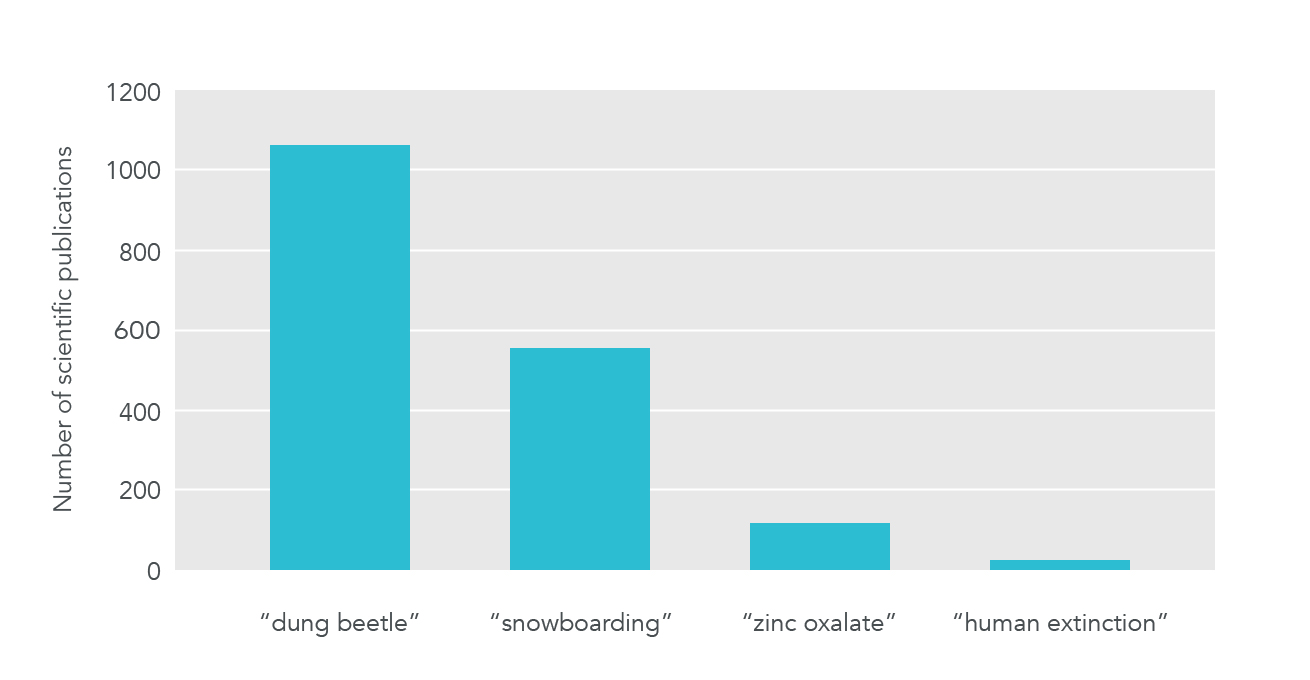

Если говорить о внимании научного сообщества к различным вопросам, то и там можно увидеть похожую картину (хотя некоторым отдельным рискам уделяется значительное внимание — например, изменению климата):

Источник: Ник Бостром

Насколько мы знаем, если посмотреть на распределение внимания в политике, то всё будет примерно так же, как и с финансированием. Подавляющее количество политического внимания уделяется конкретным вопросам, нацеленным на краткосрочную помощь ныне живущим поколениям, поскольку именно это приносит голоса. Катастрофические риски получают намного меньше внимания: из них в первую очередь говорят об изменении климата, в то время как о проблемах вроде пандемий и искусственного интеллекта упоминают реже всего.

Такое распределение ресурсов, а также научного и политического внимания, напрямую следует из текущих экономических предпосылок. Именно поэтому работа над этими рисками — это отличная возможность для тех, кто хочет сделать мир лучше.

Во-первых, ответственность за эти риски не лежит на каком-либо одном государстве. Предположим, США инвестируют значительные средства в предотвращение изменения климата. Это будет выгодно всему миру, но в США проживает только около 5% населения планеты, и граждане США получат только 5% выгоды от этих расходов. Поэтому США будет значительно занижать свои инвестиции в эту область относительно её реальной значимости для всего мира. И то же самое можно сказать обо всех других странах.

Эту проблему можно было бы решить, если все скоординируются — в случае, если каждая страна согласится внести свой соответствующий вклад в уменьшение климатических изменений, все страны выиграют и смогут избежать наихудших последствий.

К сожалению, с точки зрения каждой отдельной страны будет лучше, если все другие страны сократят свои выбросы, а её собственная экономика останется нетронутой. Поэтому у каждой страны есть стимул не соблюдать климатические соглашения, и именно поэтому в этом вопросе достигнуто так мало прогресса (это называется "дилемма заключённого").

Более того, в таком её описании проблема всё равно будет сильно преуменьшена. Больше всего пользы от снижения катастрофических рисков получают будущие поколения. У них нет возможности отстаивать свои интересы — будь то экономически или политически.

Если бы будущие поколения могли голосовать на наших выборах, подавляющее большинство из них голосовало бы за принятие законов, повышающих безопасность человечества. А если бы будущие поколения могли присылать деньги в прошлое, они были бы готовы заплатить нам огромные суммы денег за снижение этих рисков. (Технически говоря, снижение этих рисков является глобальным общественным благом на уровне поколений, что логичным образом делает его одним из самых недооценённых способов приносить пользу миру.)

Наша нынешняя система плохо справляется с защитой будущих поколений. Мы знаем людей, которые разговаривали с высокопоставленными лицами в правительстве Великобритании, и многие из этих чиновников хотят что-то сделать с этими рисками, но, по их словам, давление новостных и избирательных циклов мешает уделять должное внимание этим вопросам. В большинстве стран нет государственных учреждений, в прямые обязанности которых входит снижение этих рисков.

Это удручающая ситуация, но она также таит в себе возможности. Для людей, которые действительно хотят сделать мир лучше, такой недостаток внимания означает, что есть много способов принести огромную пользу обществу.

Что можно сделать с этими рисками?

Мы рассмотрели масштабы и недооценённость этих вопросов, но что насчёт третьего критерия — разрешимости?

Эти проблемные области являются более сложными, чем привычные области вроде глобального здравоохранения. Измерять, как наши действия влияют на здоровье (по крайней мере в краткосрочной перспективе) намного проще, и за десятки лет было получено много данных о том, что лучше всего работает. Поэтому работа по снижению катастрофических рисков выглядит хуже в плане разрешимости.

Однако мы всё равно можем многое сделать, и с учётом гигантских масштабов и недооценённости этих рисков, они по-прежнему выглядят самыми важными из всех проблем.

Мы обрисуем некоторые способы снижения этих рисков, разделив их на три широкие категории:

1. Усилия, направленные на снижение конкретных рисков

Один из подходов заключается в непосредственной работе над каким-то из рисков. Существует множество конкретных предложений по борьбе с каждым из них, например:

Многие эксперты считают, что повышение эффективности эпидемиологического надзора снизит риски пандемий. Сюда могут входить технологические улучшения или более хорошие способы сбора и обработки уже существующих данных, чтобы мы могли быстрее замечать вспышки новых пандемий. А чем быстрее будет замечена новая пандемия, тем проще будет с ней справиться.

Существует множество способов повлиять на изменение климата: например, помощь в разработке более эффективных солнечных батарей или введение углеродного налога.

Если говорить про ИИ, то можно заниматься исследованиями "проблемы контроля" в информатике, чтобы снизить вероятность непреднамеренного вреда от мощных систем ИИ. В недавней статье, "Concrete problems in AI safety", описано несколько конкретных тем для исследований, но на данный момент лишь около 20 человек во всём мире исследует подобные вопросы на постоянной основе.

В области ядерной безопасности многие эксперты считают, что для использования ядерного оружия в качестве сдерживающего фактора будет достаточно гораздо меньшего количества боеголовок. Но уменьшение запасов боеголовок также снизит риски случайных аварий, а также вероятность того, что ядерная война, если она случится, уничтожит цивилизацию.

Подробнее о том, что вы можете сделать для борьбы с каждым из рисков, мы рассказываем в наших обзорах проблем:

В этой категории мы не говорим о природных рисках, потому что они намного менее вероятны, и потому что человечество уже многое делает для борьбы с некоторыми из них. Повышение уровней богатства и технологического развития делает нас более устойчивыми к природным рискам, а на эти цели и так уже тратится огромное количество наших ресурсов.

2. Общие усилия по снижению рисков

Вместо того чтобы пробовать снизить каждый риск по отдельности, мы можем попытаться сделать так, чтобы цивилизация в целом лучше с ними справлялась. Общие усилия помогают снизить все риски сразу — даже те, о которых мы ещё не думали.

Например, есть лица, принимающие ключевые решения, — обычно работающие в правительствах, — которым придётся работать с этими рисками по мере их возникновения. Если мы могли бы улучшить процессы принятия решений этими людьми и учреждениями, то это бы сделало общество более устойчивым в целом, а также решило бы многие другие проблемы.

Недавние исследования выявили множество способов улучшить качество принятия решений, но большинство из них ещё не было внедрено. При этом мало кто работает над этой задачей. Мы разбираем эту тему более подробно в нашей статье об улучшении институционального принятия решений.

Другой пример: мы можем попытаться сделать так, чтобы цивилизации было легче восстановиться после катастрофы. Всемирное хранилище семян — это замороженное хранилище в Арктике, в котором находятся семена многих важных сортов сельскохозяйственных культур. Его существование снижает шанс того, что мы навсегда потеряем какой-то из них. Недавно туннель, ведущий к хранилищу, был залит талой водой, которая, по иронии судьбы, образовалась в результате климатических изменений, поэтому проекту могло бы пригодиться дополнительное финансирование. Можно было бы разработать много других подобных проектов для сохранения наших знаний.

Также мы могли бы построить более хорошие убежища на случай чрезвычайных ситуаций, что снизило бы шансы вымирания человечества в результате пандемий, ядерной зимы и ударов астероидов (но не помогло бы в случае рисков от ИИ), а ещё повысило бы шансы успешного восстановления после катастрофы. На данный момент подобные меры выглядят менее эффективными, чем усилия по снижению самих рисков, но они всё равно полезны. Более недооценённым, а также возможно намного более дешёвым вариантом будет создание альтернативных источников пищи — например, таких, которым не нужен свет, и чьё производство можно быстро нарастить в условиях длительной зимы.

Поскольку общие усилия приносят пользу, даже если мы не уверены в деталях рисков, их привлекательность возрастает при увеличении неопределённости. Соответственно, чем более ясными и актуальными становятся риски, тем больше ресурсов нужно перенаправлять на работу с конкретными рисками (подробнее об этом).

Мы ожидаем, что есть много других перспективных способов снижать риски в целом, но эта область крайне мало изучена. К примеру, ещё один подход мог бы быть основан на улучшении международной координации. Поскольку эти риски вызваны человечеством, человечество может их предотвратить, но нам мешают проблемы координации. К примеру, Россия не хочет разоружаться, потому что это поставит её в невыгодное положение по сравнению с США, и наоборот, хотя обе страны выиграли бы от отсутствия возможности ядерной войны.

Однако можно попробовать улучшить нашу способность координироваться на масштабах цивилизации: например, при помощи улучшения международных отношений или создания более эффективных международных институтов. Мы хотели бы видеть больше исследований на подобные темы.

Популярные способы делать мир лучше, вроде работы над образованием или международным развитием, могут помочь обществу стать более устойчивым и разумным, поэтому тоже положительно влияют на снижение катастрофических рисков. Например, более образованное население скорее всего голосовало бы за более разумных лидеров, а более развитые страны (при прочих равных) лучше справляются с пандемиями — неслучайно вспышки вируса Эбола сконцентрировались в некоторых из беднейших районов Западной Африки.

Но мы не считаем образование и здравоохранение лучшими направлениями для приложения усилий по двум причинам. Во-первых, этим областям и так уделяется гораздо больше внимания, чем более нестандартным подходам, о которых мы говорили. К примеру, работа над улучшением системы образования является чуть ли не самым популярным направлением среди людей, которые хотят приносить пользу миру. В одних лишь Штатах образование получает 800 миллиардов долларов в год от государства, а также ещё триллион долларов частного финансирования. Во-вторых, влияние этих подходов на снижение экзистенциальных рисков довольно расплывчато — чтобы получить заметный эффект, нужно улучшить образование в очень больших масштабах. Поэтому мы предпочитаем работать над более конкретными и недооценёнными решениями.

3. Расширение знаний и наращивание потенциала

Мы крайне не уверены в том, какие риски являются наиболее значимыми, что с ними лучше всего делать, и какова вероятность того, что мы кардинально ошибаемся в наших представлениях о глобальных приоритетах. Это означает, что ещё одна ключевая цель — получше разобраться во всех этих вопросах.

Мы можем получить больше информации, просто пробуя снизить эти риски и наблюдая за тем, какого прогресса получается достичь. Однако мы считаем, что наиболее недооценённым и важным способом расширить наши знания уже сейчас являются исследования глобальных приоритетов.

Эта область находится на стыке экономики и моральной философии, а её цель — найти ответы на общие вопросы о наиболее важных проблемах для человечества. Лишь маленькая группа исследователей работает над этими вопросами на постоянной основе.

Другой способ работать с неопределённостью — накапливать ресурсы для использования в будущем, когда будет больше информации. Например, можно зарабатывать и откладывать деньги. Также можно инвестировать в свой карьерный капитал (особенно в переносимые навыки и полезные связи), чтобы добиться большего в будущем.

Однако мы считаем, что ещё более эффективным подходом может быть создание сообщества, ориентированного на снижение таких рисков — какими бы они не были. Дело в том, что развивать потенциал сообщества можно быстрее, чем в одиночку наращивать свой финансовый или карьерный капитал. Например, если потратить год на нетворкинг с целью привлечь перспективных людей к работе над глобальными проблемами, вполне реально найти ещё одного человека с релевантной экспертизой, который будет готов работать с вами. Таким образом, за год работы вы удвоите количество усилий, которые благодаря вам идут на решение важнейших проблем.

На данный момент мы вкладываем наши усилия в развитие сообщества эффективного альтруизма, в котором много людей, стремящихся снизить экзистенциальные риски. Более того, недавние темпы роста и исследования конкретных инициатив по развитию сообщества говорят о потенциально высокой эффективности этого подхода для улучшения мира.

Однако мы ожидаем, что усилия по созданию других сообществ тоже будут ценными. Мы были бы рады увидеть сообщество учёных, стремящихся продвигать культуру безопасности в академических кругах. Было бы здорово увидеть сообщество политиков, которые хотят снизить экзистенциальные риски и сделать так, чтобы их правительство начало больше заботиться о будущих поколениях.

Сейчас снижением экзистенциальных рисков занимается очень мало людей, поэтому мы полагаем, что есть много возможностей для организации общественного движения вокруг этих проблем.

В целом, насколько снижать экзистенциальные риски эффективно?

Учитывая все подходы к снижению этих рисков, а также то, как мало ресурсов выделяется на борьбу с некоторыми из них, есть причины полагать, что существенный прогресс возможен.

На самом деле, даже если рассматривать влияние этих рисков только на нынешнее поколение (игнорируя любые выгоды для будущих поколений), то они с большой вероятностью окажутся наиболее приоритетными.

Чтобы это проиллюстрировать, мы приведём несколько грубых и упрощённых цифр, которые, тем не менее, кажутся нам реалистичными: если потратить $100 миллиардов на борьбу с экзистенциальными рисками, то за следующий век можно было бы снизить их шансы более чем на 1%. Снижение этих рисков на один процент спасло бы, согласно математическому ожиданию, около 100 миллионов жизней из нынешнего поколения (1% от примерно 10 миллиардов людей, живущих сейчас). И это означало бы, что на спасение одной жизни мы тратим всего лишь 1000 долларов.31

Грег Льюис сделал более подробные расчёты, согласно которым средняя стоимость года жизни для человека нынешнего поколения составляла бы $9200 (т.е. примерно $300 000 за одну жизнь).32 В его отчёте также есть и другие оценки. Мы считаем, что Грег, скорее всего, слишком консервативен, потому что он предполагает, что риск вымирания в течение следующего столетия равен 1%, в то время как наша оценка в несколько раз выше. Мы также считаем, что следующий миллиард долларов, который будет потрачен на снижение экзистенциальных рисков, может дать больший эффект, чем предполагает Грег (но стоит отметить, что это утверждение справедливо только при условии, что этот миллиард будет потрачен на самые недооценённые риски, такие как безопасность в сфере ИИ и биориски). Поэтому мы бы не удивились, если бы для следующего миллиарда долларов, направленного на снижение экзистенциальных рисков, стоимость спасения жизни одного человека из нынешнего поколения была бы менее $100.

Одним из лучших способов помочь нынешнему поколению часто называют пожертвования в Against Malaria Foundation (AMF), которая лидирует в рейтинге лучших благотворительных организаций от GiveWell. AMF позволяет спасти одну жизнь примерно за $7500 (по оценкам на 2017 год).33 Таким образом, вышеупомянутые оценки показывают, что снижение экзистенциальных рисков более эффективно (или по крайней мере сравнимо по эффективности) по затратам на одну спасённую жизнь, чем деятельность AMF — благотворительной организации, которую выбрали именно из-за её выдающихся успехов в этой области.

Точно также мы считаем, что если 10 000 талантливых молодых людей сосредоточили бы свою карьеру на этих рисках, они смогли бы снизить их где-то на 1%. Это значит, что каждый из них смог бы, согласно математическому ожиданию, спасти 1000 жизней на протяжении своей карьеры, что, скорее всего, больше, чем если бы они просто зарабатывали и жертвовали деньги в Against Malaria Foundation.34

С одной стороны, это несправедливые сравнения, потому что рейтинг GiveWell гораздо лучше исследован и обоснован, в то время как наша оценка скорее является разумным предположением. Также могут быть и более эффективные способы помочь нынешнему поколению, чем AMF (например, продвижение определённых законов).

Однако мы также сильно приуменьшили полезность снижения экзистенциальных рисков. Главной причиной для защиты цивилизации является не нынешнее поколение, а помощь будущим поколениям. Мы не учитывали их в этой оценке.

Если учитывать и будущие поколения тоже, то эффективность снижения экзистенциальных рисков становится на порядки выше. В таком случае сложно представить что-то ещё более приоритетное на данный момент.

А теперь вы можете либо почитать разбор некоторых ответов на эти аргументы, либо сразу перейти к разделу о том, как вы можете поучаствовать в снижении этих рисков.

Кому не стоит фокусироваться на защите будущего?

Представленные в этой статье аргументы основываются на предпосылках, с которыми согласятся не все. В этом разделе мы разберём некоторые из известных нам возражений.

Мы говорим лишь о том, какими должны быть приоритеты в том случае, если вы стараетесь помочь людям в целом, в равной степени рассматривая интересы каждого (философы иногда называют эту позицию "беспристрастным альтруизмом").

Большинство людей считают хотя бы сколько-то важным помогать другим: если вы можете помочь незнакомцу без особых затрат для себя, то это стоит сделать. Люди также заботятся о собственном благополучии, а также о своих друзьях и близких — и тут мы ничем не отличаемся.

Как найти баланс между этими приоритетами — сложный вопрос. Если вам повезло и вы можете позволить себе делать вклад в улучшение мира, то мы считаем, что защита будущего должна стать главным приоритетом. В следующем разделе мы предлагаем несколько конкретных способов поучаствовать в этой инициативе.

В противном случае, вам может быть нужно сосредоточиться на своей личной жизни, а поучаствовать в защите цивилизации можно в свободное время или в будущем.

У нас нет надежных оценок многих рисков, вызванных деятельностью человека, поэтому вы можете попробовать оценить их самостоятельно и прийти к выводу, что они гораздо ниже, чем предполагаем мы. Если эти риски окажутся достаточно низкими, то их снижение перестанет быть главным приоритетом.

Более низкие оценки не кажутся нам правдоподобными по причинам, описанным выше. Если рассмотреть все возможные экзистенциальные риски, то трудно утверждать, что их суммарная вероятность будет меньше 1% на протяжении ближайших ста лет, и даже риск в 1% скорее всего требует гораздо более активного вмешательства, чем то, что мы наблюдаем сегодня.

Мы оцениваем эти риски как менее "разрешимые" по сравнению с проблемами вроде глобального здравоохранения, поэтому ожидаем более медленного прогресса за единицу вложений. Тем не менее, мы считаем, что их масштабы и недооценённость с лихвой компенсируют этот факт, и по сумме факторов работа над ними будет более эффективной. Многие считают, что эффективный альтруизм поддерживает только научно обоснованные вмешательства, но это миф. Если ожидаемые результаты достаточно высоки, имеет смысл браться даже за задачи с маленькой вероятностью успеха. Ведущий спонсор в нашем сообществе выступает за подход "оправданных рисков" в благотворительности.

Однако если вы гораздо более пессимистично оцениваете шансы достижения прогресса в снижении экзистенциальных рисков, то, возможно, вам стоит работать над более стандартными проблемами вроде глобального здравоохранения.

Возможно, мы бы и сами переключились на другие вопросы, если бы в снижение экзистенциальных рисков вкладывалось в 100 раз больше ресурсов, чем сейчас. Но до этого ещё далеко.

Ещё одно возражение заключается в том, что мы уже и так принимаем наилучшие меры для снижения этих рисков. Такая ситуация означала бы, что смены приоритетов не требуется. Например, раньше мы упоминали, что образование, скорее всего, помогает снижать эти риски. Если вы считаете, что улучшение образования — это самый эффективный способ снижать экзистенциальные риски (например, потому что у вас очень высокая степень неопределённости насчёт того, какие риски будут наиболее актуальными), то тогда, поскольку человечество уже вкладывает огромное количество ресурсов в образование, вы можете считать, что ситуация уже и так под контролем. Такой вывод не кажется нам правдоподобным, поскольку, как уже было сказано, существует множество неиспользованных возможностей для снижения этих рисков, которые выглядят более конкретными и недооценёнными.

Другой пример: экономисты иногда утверждают, что нам следует просто сосредоточиться на экономическом росте, поскольку это позволит нам наилучшим образом справиться с рисками в будущем. Это не кажется нам убедительным, поскольку некоторые виды экономического роста увеличивают риски (например, открытие нового оружия), поэтому нельзя утверждать, что экономический рост однозначно является одним из лучших способов снижения рисков. Вместо этого мы бы сфокусировались хотя бы на избирательном технологическом развитии или других более прицельных усилиях, перечисленных выше.

Хотя снижение этих рисков имеет смысл и для нынешнего поколения, большая часть их важности обусловлена долгосрочными последствиями — если цивилизации придёт конец, мы полностью потеряем всё будущее.

Вы можете считать, что нашему поколению доступны и другие действия с очень долгосрочными последствиями, которые могут быть столь же важны для снижения риска вымирания. В частности, мы могли бы улучшить качество будущего, защитив нашу цивилизацию от риска навсегда застрять в каком-то из негативных сценариев.

Это может быть немного похоже на научную фантастику, но всё же: иногда люди рассуждают о возможности того, что новые технологии, такие как тотальная массовая слежка или психологический контроль, могут привести к созданию тоталитарного правительства, которое никогда не получится свергнуть. Подобные сценарии были описаны в книгах "1984" и "Дивный новый мир", соответственно. Если такое правительство окажется плохим, то цивилизацию могут ждать тысячи лет страданий, что ещё хуже, чем вымирание.

Другие высказывают опасения, что разработка продвинутых систем ИИ может нанести страшный вред, если будет вестись безответственно: например, из-за конфликта между несколькими группами, ставящими своей целью разработку этой технологии. В частности, если в будущем разработка этих систем приведёт к появлению разумных цифровых существ, то вопрос их благополучия может стать крайне важным.

Риски сценариев будущего, в которых присутствует астрономическое количество страданий, были названы "s-рисками".35 Если сегодня можно сделать что-то для предотвращения s-рисков (например, при помощи целенаправленных исследований в областях технической безопасности и регулирования ИИ), то это может быть ещё более важным.

Ещё одна область, на которую следует обратить внимание, это крупные технологические переходы. В этой статье мы говорили об опасностях генной инженерии и искусственного интеллекта, но внедрение этих технологий также может привести к ещё одной индустриальной революции и сделать очень много хорошего. Возможно, есть действия, которые позволят нам повысить вероятность благополучного перехода, а не снизить риски плохого. Это называют попытками повысить "экзистенциальную надежду", в отличие от снижения "экзистенциальных рисков".36

Мы согласны с тем, что могут быть и другие способы добиться очень долгосрочных эффектов, и что они могут быть более важными, чем снижение риска вымирания. Однако большинство этих предложений ещё недостаточно хорошо проработаны, и у нас нет чёткого понимания о том, что с ними делать.

Изучив другие способы влияния на будущее, мы сделали важный практический вывод — теперь мы считаем, что управлять переходами к новым революционным технологиям, таким как ИИ, ещё более важно. Мы также хотели бы видеть больше исследований глобальных приоритетов, посвящённых этим вопросам.

В целом, мы по-прежнему считаем, что сначала стоит сосредоточиться на снижении экзистенциальных рисков, после чего можно будет перейти к другим способам помощи будущему.

Один из таких способов, который не кажется нам хорошей альтернативой, — это ускорение прогресса. Некоторые из тех, кто хочет помочь будущему, фокусируются на технологическом прогрессе (например, разрабатывают вакцины), и у этого действительно есть позитивные долгосрочные последствия. Но мы считаем, что с долгосрочной точки зрения более важным является то, где мы окажемся, а не то, как быстро мы туда попадём. Открытие новой вакцины скорее всего означает, что мы получили её раньше, а не то, что иначе она вообще бы не появилась.

Более того, поскольку технологии также являются причиной многих из этих рисков, мы не знаем, насколько ускорение их развития будет полезным в краткосрочной перспективе.

Ускорение прогресса также получает намного больше внимания, поскольку приносит пользу и нынешнему поколению. Как мы уже писали, ежегодно на исследование и развитие новых технологий тратится более 1 триллиона долларов. Поэтому ускорение прогресса одновременно и менее приоритетно, и менее недооценено.

О других способах помощи будущим поколениям можно прочитать в третьей главе диссертации Ника Бекстеда, "On the Overwhelming Importance of Shaping the Far Future".

Если вы считаете, что недолгое существование цивилизации практически гарантировано, то ценность снижения экзистенциальных рисков значительно снижается (хотя таким образом всё равно можно помочь нынешнему поколению, а также небольшому числу будущих поколений).

Мы согласны, что существует значительная вероятность скорого конца цивилизации (именно поэтому этот вопрос так важен), но мы также считаем, что существует достаточно большая вероятность того, что она может просуществовать очень долго, и поэтому за будущее стоит бороться.

Аналогично, если вы считаете, что будущее скорее будет плохим, чем хорошим, то ценность снижения этих рисков падает (или если вы считаете, что намного важнее снижать страдания, чем повышать благополучие). Однако нам не кажется, что это вероятно, поскольку люди хотят хорошего будущего и поэтому постараются сделать его таковым. Мы также считаем, что за последние несколько столетий произошел значительный моральный прогресс (благодаря тенденциям, отмеченным ранее), и мы полагаем, что он продолжится. См. более подробное обсуждение в сноске 11.37

Более того, даже если вы не уверены, насколько хорошим будет будущее, или подозреваете, что оно окажется плохим (но в тех аспектах, с которыми мы в принципе сможем справиться), у вас всё равно могут быть причины хотеть, чтобы цивилизация выжила и сохранила возможность различных сценариев развития. У людей будущего будет гораздо больше времени на изучение того, стоит ли цивилизации расширяться, оставаться тех же размеров или уменьшиться. Если вы считаете, что есть неплохие шансы того, что мы сможем учесть подобные этические вопросы, то это будет хорошей причиной положиться на мудрость будущих поколений и оставить последнее слово за ними. В целом, степень нашей неопределённости по поводу этих сложных вопросов крайне высока, но это скорее увеличивает наше стремление избежать любых необратимых сценариев.38

Кроме этого, вам, скорее всего, стоит сосредоточиться на способах снижения вероятности плохого будущего, таких как предотвращение s-рисков.

Если вы уверены, что у нас гораздо больше обязательств перед нынешним поколением, чем перед будущими (например, потому что придерживаетесь этического принципа "воздействия на конкретного человека"), то важность снижения экзистенциальных рисков уменьшается. Лично нам этот подход не кажется особо убедительным.

При этом мы показали, что даже если игнорировать будущие поколения, эти риски кажутся достойными внимания. Работая над ними, можно относительно дёшево спасти жизни нынешнего поколения, а ещё избежать многих страданий от катастроф среднего масштаба.

Более того, если вы не уверены, есть ли у нас моральные обязательства перед будущими поколениями, тогда вам опять же следует оставить возможность для различных сценариев, а для этого нужно сохранить цивилизацию.

Тем не менее, если одновременно придерживаться позиции о том, что у нас нет серьёзных обязательств перед будущими поколениями, и о том, что с экзистенциальными рисками мало что можно поделать, или же что нет полезных исследований, которые можно было бы провести, то тогда на первое место может выйти какой-то другой способ помощи текущим поколениям. Это может быть работа в области ускорения развития технологий, глобального здравоохранения или ментального здоровья. Или же вы можете решить, что есть более важные этические проблемы, такие как промышленное животноводство.

Хотите поучаствовать в снижении экзистенциальных рисков?

Наше поколение может либо приблизить конец всего, либо провести человечество через самый опасный период и стать одним из самых важных поколений в истории.

Мы можем стать либо теми, кто сделает возможным достижение поразительного и процветающего мира, либо теми, кто поставит всё под угрозу.

Поскольку мы хотим помочь миру, этот выбор должен быть нашим главным приоритетом.

Если вы хотите построить свою карьеру вокруг снижения экзистенциальных рисков и защиты будущего, мы хотим вам помочь. Мы написали статью, в которой описаны различные варианты действий, а также первые шаги, которые вы можете сделать.

Как задействовать свою карьеру для снижения экзистенциальных рисковПосле прочтения этой статьи, или же если вы уже подумали о том, чем именно хотите заниматься, рассмотрите возможность поговорить с нами лично. Мы поможем вам взвесить различные решения и сформулировать план.

Записаться на индивидуальную консультациюДальнейшее чтение

Прочитайте о 51 идее в областях политики и научных исследований, которые могут помочь снизить экзистенциальные риски.

Ознакомьтесь с академической версией наших доводов в этой статье профессора Ника Бострома.

Изучите аргументы о том, почему нужно сфокусироваться на будущих поколениях.

Прочитайте альтернативную вводную статью о том, почему наше влияние на будущие поколения чрезвычайно важно с моральной точки зрения (в ней также есть раздел с возражениями).

Послушать про экзистенциальные риски и связанные с ними темы можно в наших подкастах с Тоби Ордом и Ником Бекстедом, а также в других эпизодах подкаста, посвящённых конкретным видам рисков.

Послушайте интервью с Томасом Мойниханом про историю развития мысли в области экзистенциальных рисков.

А ещё мы рекомендуем наш подкаст с Карлом Шульманом, где мы обсуждаем простые и понятные аргументы в пользу работы над экзистенциальными рисками, а также практические выводы, которые из этого следуют.

Читайте дальше: Наш век может оказаться самым важным в истории

Почему разработка продвинутых систем ИИ вместе со стремительным экономическим ростом и научным прогрессом, которые за этим последуют, может привести нас к крайне необычному будущему значительно быстрее, чем кажется большинству людей — и почему это делает 21-ый век самым важным в истории.

Оставьте свой имейл, и мы пришлём вам книгу (бесплатно)

Подпишитесь на нашу рассылку, и мы пришлём вам бесплатный экземпляр «На краю пропасти» («The Precipice») — книги философа Тоби Орда о том, как подступиться к величайшим угрозам, с которыми сталкивается человечество.

!social-share

Notes and references

- ↩

- Ник Бостром определяет понятие экзистенциального риска как некое событие, которое "может привести к вымиранию человечества или необратимо и радикально ограничить его потенциал". Экзистенциальный риск отличается от риска глобальной катастрофы (РГК) по масштабу — РГК является катастрофичным в планетарном масштабе, но допускает возможность последующего восстановления. Насколько мы понимаем, термин "экзистенциальная угроза" обычно используется как усиление, с целью представить некую проблему как более ужасную.↩

- Гринберг опрашивал пользователей Mechanical Turk, чей средний возраст — 20-40 лет, а уровень образования, как правило, выше среднего, поэтому опрос не отражает мнения всех американцев. Подробнее смотрите в этом видео:

Social Science as Lens on Effective Charity: results from four new studies - Spencer Greenberg, таймкод 12:15.

Первоначальный опрос показал, что медианная оценка шансов вымирания человечества в течение 50 лет составляет 1 на 10 миллионов. Гринберг провел три повторных исследования, которые дали более высокие оценки. Самая высокая из них показала медиану в 1/100. Однако даже в этом случае 39% респондентов все равно предположили, что шансы были ниже, чем 1 на 10 000 (что примерно равно шансам столкновения Земли с астероидом диаметром в 1 км). Во всех случаях более 30% считали, что шансы меньше, чем 1 на 10 миллионов. Сводку всех опросов можно посмотреть здесь.

Обратите внимание: когда мы спрашивали людей о шансах вымирания без конкретных временных рамок, оценки были гораздо выше. В одном из опросов медианное значение ответов составило 75%. Их можно понять: человечество когда-нибудь вымрет. Это помогает объяснить расхождение с некоторыми другими опросами. Например, исследование "Climate Change in the American Mind" (май 2017 года, архивная ссылка) показало, что медианный американец считает, что шансы вымирания в результате изменения климата составляют примерно 33%. Однако в этом исследовании не задавался вопрос о конкретных сроках. Когда Гринберг попытался воспроизвести результат с тем же вопросом, он получил аналогичную цифру. Но когда Гринберг спросил о шансах вымирания в результате изменения климата в ближайшие 50 лет, медиана упала до 1%. Многие другие исследования также некорректно обращаются с низкими оценками вероятности — люди обычно не дают оценку в 0,00001%, если такой вариант не был изначально предложен.

Однако, как можно заметить, подобные опросы обычно дают очень ненадёжные результаты. Ответы респондентов зависят от конкретной формулировки вопроса и от контекста. Отчасти это связано с тем, что люди очень плохо оценивают низкие вероятности. Из-за этого трудно дать точную оценку того, что думает население в целом, однако ничто из полученных данных не опровергает идею о том, что значительное число людей (скажем, более 25%) считает, что шансы вымирания человечества в краткосрочной перспективе крайне малы и скорее всего даже ниже, чем вероятность столкновения с астероидом. Более того, флуктуации этих оценок не добавляют уверенности в том, что человечество рационально учитывает эти риски.↩

- > Чтобы привести к вымиранию человечества, столкнувшийся с Землёй объект скорее всего должен быть больше 1 км в диаметре (а если точнее, то где-то в районе 3-10 км). На Земле произошло по крайней мере пять, а может и более десятка массовых вымираний, и по крайней мере некоторые из них, по всей видимости, были вызваны падениями метеоритов ([9], стр. 81 и далее). В частности, К-Т вымирание (в результате которого вымерли динозавры), случившееся 65 миллионов лет назад, связывают с падением астероида диаметром от 10 до 15 км на полуостров Юкатан. По оценкам, тело диаметром от 1 км сталкивается с Землёй примерно раз в 0,5 миллиона лет. Мы знаем лишь о небольшой части потенциально опасных тел.

Bostrom, Nick. "Existential risks: Analyzing human extinction scenarios and related hazards." (2002). Архивная ссылка, получена 21.10.2017.↩

- Указаны шансы упасть в Атлантический океан на самолете A330 компании Virgin, летящем из Хитроу в Кеннеди (1 на 5,4 миллиона). Таким образом, вам нужно сделать 1000 перелётов, чтобы вероятность попадания в авиакатастрофу для вас сравнялась с вероятностью попасть в катастрофу из-за столкновения астероида с Землёй.

A crash course in probability, The Economist, 2015.

- Достаточно большой супервулкан тоже может вызвать долгую зиму, которая положит конец жизни. К другим природным рискам можно отнести особо смертоносную пандемию, вспышку близкой к нам сверхновой или гамма-всплеск, или же вызванное естественными причинами необратимое изменение климата.↩

- С кратким изложением этой статьи можно ознакомиться в лекции "Dr Toby Ord - Will We Cause Our Own Extinction? Natural versus Anthropogenic Extinction Risks", прочитанной в CSER в Кембридже в 2015 году. Ссылка.↩

- График взят из Maddison, Angus (2007): "Contours of the World Economy, 1-2030 AD. Essays in Macro-Economic History," Oxford University Press, ISBN 978-0-19-922721-1, стр. 379, таблица A.4.↩

- How big a deal was the Industrial Revolution?, by Luke Muehlhauser, 2017, Архивная ссылка, получена 21.10.2017.↩

- Pinker, S., 2011. The better angels of our nature: The decline of violence in history and its causes. Penguin uk. Web↩

- В 2020 году вышел перевод книги на русский язык под названием "Лучшее в нас. Почему насилия в мире стало меньше". — Прим. перев.↩

- Различные опросы дают очень разные результаты насчёт того, насколько люди пессимистичны в отношении будущего, но многие из опросов показывают, что по мнению большинства мир становится хуже. Например, недавний государственный опрос в Великобритании показал, что 71% респондентов придерживаются такого мнения.

Declinism: is the world actually getting worse?, Pete Etchells, The Guardian, 2015, Архивная ссылка, получена 17.10.2017↩

- Становится ли мир лучше?

Хотя есть причины считать, что большинство показателей прогресса растут (как показано в статье), есть также некоторые аспекты жизни, которые могли стать хуже. Например, в книге "Sapiens" Юваль Харари утверждает, что в современную эпоху усилились проблемы одиночества и психического здоровья, в то время как ощущения значимости и смысла могли снизиться. Мы скептически относимся к тому, что эти минусы могут перевешивать плюсы, но сложно сказать наверняка.

Более сильные аргументы в пользу того, что мир становится хуже, возникают в контексте нашего воздействия на животных. В частности, с 1960-х годов резко выросло промышленное животноводство, и сейчас где-то 30+ миллиардов животных ежегодно живут в ужасных условиях на промышленных фермах. Если нам небезразличны страдания этих животных, то это может перевесить наши успехи в области человеческого благополучия.

Учитывая все эти аргументы, мы не можем однозначно утверждать, что суммарное благополучие возросло. Однако более важным является вопрос о том, что нас ждет в будущем.

Станет ли мир лучше?

Мы считаем, что до тех пор, пока человечество существует, развитие технологий и моральный прогресс дают нам возможности справиться с самыми серьёзными социальными проблемами, а также жить гораздо лучше в будущем. Если не считать экзистенциальные угрозы, то многие конкретные глобальные проблемы могут быть решены, если уровни богатства, технологического развития, а также морального и политического прогресса будут и дальше повышаться.

Например, в случае с промышленным животноводством мы ожидаем, что по мере того, как люди будут становиться богаче, проблема будет уменьшаться. Во-первых, богатые люди более склонны к этичному потреблению, потому что в большей степени могут себе это позволить. Во-вторых, технологии способны положить конец промышленному животноводству при помощи заменителей мяса, искусственно выращенного мяса или более гуманных методов ведения сельского хозяйства. В-третьих, моральная значимость других живых существ возросла с течением времени ("расширяющийся круг заботы"), поэтому мы ожидаем, что в будущем люди будут ещё больше заботиться о благополучии животных.

Если посмотреть ещё шире, то в конечном счёте мы ожидаем, что будущее будет лучше, потому что люди сами этого хотят. Чем больше технологической мощи и личных свобод мы имеем, тем проще людям реализовывать свои ценности. Поскольку люди хотят жить хорошо, улучшение будущего — более вероятный сценарий, чем его ухудшение.

При этом остаётся много вопросов. Например, многие наши ценности в какой-то степени противоречат друг другу, и это может привести к конфликтам. Вопросы о том, что ждёт нас в будущем, мало изучены. Поэтому хотя мы и ожидаем, что будущее будет лучше, чем наш мир сейчас, мы также признаём значительную степень неопределённости.↩

- Больше об истории подобных случаев можно узнать в нашем подкасте с Тоби Ордом.↩

- > Пятьдесят лет назад Кубинский ракетный кризис поставил мир на грань ядерной катастрофы. Во время конфликта президент Джон Ф. Кеннеди считал, что вероятность начала войны была "между 33-мя и 50-ю процентами", и в последующие десятилетия ничто не дало нам причин оценить эту вероятность как более низкую. Такой конфликт мог бы привести к гибели 100 миллионов американцев и более 100 миллионов россиян.

At 50, the Cuban Missile Crisis as Guide, Graham Allison, The New York Times, 2012,

Архивная ссылка, получена 17.10.2017↩

- Оценки шансов ядерного удара по гражданской цели указаны по ссылке ниже, на рисунке в разделе "What is the probability that a nuclear bomb will be dropped on a civilian target in the next decade?” Обратите внимание, что один эксперт оценил шанс ядерного удара по гражданской цели в ближайшие 10 лет менее чем в 1%.

Правда ли, что экспертов больше беспокоит индийско-пакистанский конфликт, чем Северная Корея?

> Первое место в списке конфликтов, вызывающих опасения экспертов, занимает Индия-Пакистан. Оба государства разработали ядерное оружие вне юрисдикции Договора о нераспространении ядерного оружия, оба государства имеют ограниченные военные возможности, что может стать причиной раннего применения, и известно, что оба государства (хоть их публичные заявления и намеренно расплывчаты) имеют планы на случай чрезвычайных обстоятельств, предполагающие первые ядерные удары по военным целям.

We’re Edging Closer To Nuclear War, Milo Beckman, FiveThirtyEight, 2017,

Архивная ссылка, получена 17.10.2017↩

- Когда "ядерная зима" стала предметом беспокойства?

> "Ядерная зима" и предшествующая ей концепция, "ядерные сумерки", относятся к ядерным событиям. Ядерная зима стала интересна науке в 1980-х годах, после того как стало ясно, что более ранняя гипотеза про разрушение озонового слоя из-за выбросов оксидов азота от огненных шаров начинает терять свою достоверность. Именно в этом контексте климатическое воздействие сажи от пожаров было "случайно обнаружено" и вскоре стало основной теорией в области климатических последствий ядерной войны. В этих модельных сценариях предполагалось, что над городами, нефтеперерабатывающими заводами и ракетными шахтами в сельских районах образуются облака, содержащие неопределённое количество сажи. После того как исследователи задавали количество сажи, моделировались климатические эффекты этих облаков. Термин «ядерная зима» был придуман в 1983 году Ричардом П. Турко в связи с одномерной компьютерной моделью, созданной для изучения идеи «ядерных сумерек». На основе этой модели был сделан вывод, что огромное количество сажи и дыма будет годами держаться в воздухе и станет причиной сильного падения температуры на всей планете. Турко позже дистанцировался от этих радикальных 1-D выводов."

Статья "Nuclear Winter" на Википедии, архивная ссылка, получена 30.10.2017.↩

- Климатические модели содержат значительную неопределённость, и это значит, что реальные риски запросто могут быть выше. Более того, из-за самого факта наличия неопределённости в моделях сложно приписывать очень низкие вероятности большинству рисков. Об этом можно почитать в следующей работе:

Ord, T., Hillerbrand, R., & Sandberg, A. (2010). Probing the improbable: methodological challenges for risks with low probabilities and high stakes. Journal of Risk Research, 13(2), стр. 191-205. arXiv:0810.5515v1, ссылка.↩

- Ожидаемая тяжесть ядерной зимы всё ещё обсуждается, и Open Philantropy недавно выделила средства на дальнейшее исследование этой темы.↩

- См. Box SPM.1.1 в разделе B, Summary for Policymakers of the Working Group I Contribution to the Sixth Assessment Report of the Intergovernmental Panel on Climate Change.↩

- > По разным оценкам, погибло от 3% до 6% мирового населения.

World War One’s role in the worst ever flu pandemic, John Mathews, The Conversation, 2014, архивная ссылка, получена 27.10.2017.

> При населении мира в 1811 миллионов человек, 30 миллионов смертей привели бы к уровню смертности в 16,6 человек на каждую тысячу. Это в три раза выше, чем в богатых странах, но вполне в пределах нормы для бедных стран. Если оценивать количество смертей от гриппа в 50-100 миллионов, то числа были бы в районе 27,6-55,2 смертей на тысячу.

Patterson, K.D. and Pyle, G.F., 1991. The geography and mortality of the 1918 influenza pandemic. Bulletin of the History of Medicine, 65(1), p.4.

Архивная ссылка, получена 22.10.2017.

> В дальнейших исследованиях на тему пандемии испанского гриппа значение предполагаемой общей смертности регулярно пересматривалось в сторону увеличения. Согласно расчётам 1920-х годов, смертность оценивалась примерно в 21,5 миллиона человек. В работе 1991 года смертность была пересчитана, с новым значением в диапазоне 24,7-39,3 миллиона человек. В данной работе предполагается, что она была порядка 50 миллионов. Однако следует признать, что даже эта огромная цифра может быть значительно ниже реальной — вплоть до разницы в 100%.

Johnson, N.P. and Mueller, J., 2002. Updating the accounts: global mortality of the 1918-1920" Spanish" influenza pandemic. Bulletin of the History of Medicine, 76(1), стр. 105-115.

- Revealed: the lax laws that could allow assembly of deadly virus DNA: Urgent calls for regulation after Guardian buys part of smallpox genome through mail order, The Guardian, 2006,

Архивная ссылка, получена 21.10.2017.↩

- > Исследователи считают, что существует 50% вероятность того, что ИИ превзойдет человека во всех задачах через 45 лет.

>

> Респондентов спросили, какое влияние ВМИ окажет на человечество в долгосрочной перспективе: положительное или отрицальное. Им нужно было оценить вероятности различных исходов по пятибальной шкале. Медианными оценками были 25% для "хорошего исхода" и 20% для "чрезвычайно хорошего исхода". В свою очередь, медианная оценка для "плохого" исхода была 10%, и 5% для исхода, сформулированного как "чрезвычайно плохой (например, вымирание человечества)".

Grace, K., Salvatier, J., Dafoe, A., Zhang, B. and Evans, O., 2017. When Will AI Exceed Human Performance? Evidence from AI Experts. arXiv preprint arXiv:1705.08807.

- Если вам интересно почитать обсуждение подобной непоследовательности в оценках, читайте заметку в блоге AI Impacts, "Some Survey Results," архивная ссылка, получена 30.10.2017. К примеру:

> Вопросы, связанные с конкретными видами работы, очень сильно влияют на прогнозы касательно ВМИ. Когда мы задавали некоторым людям вопросы про то, когда ИИ начнёт успешно выполнять несколько конкретных видов деятельности, а потом и про все виды работ, которыми занимаются люди (что считается подвидом всех возможных задач вообще), мы получали сильно более поздние сроки, чем когда мы просто спрашивали про ВМИ в целом. Если при этом мы просили назвать вероятности для конкретных сроков, то для срока "через 20 лет" цифры отличались в 1000 раз! (10% для общего вопроса про сильный ИИ против 0,01% для конкретных видов деятельности.) Если же мы просили назвать сроки для конкретных значений вероятности, общий вопрос получал оценку "через 40 лет" для 50% вероятности, а формулировки про конкретные виды деятельности получали ответ "через 90 лет" для тех же 50%. > > Люди регулярно дают более поздние прогнозы, если спрашивать их про "вероятность через N лет", чем если спрашивать про "год, в который вероятность будет M". Мы наблюдали это в контексте общего вопроса про ВМИ и вопросов про конкретные виды деятельности, а также в большинстве случаев, когда мы тестировали эти вопросы на респондентах в MTurk. Например, для общего вопроса про ВМИ, если спрашивать, когда вероятность создания ВМИ достигнет 50%, то медианным ответом будет "через 40 лет", но если спрашивать, какова вероятность создания ВМИ через 40 лет, медианный ответ будет "30%".↩

- > Некоторые заявления таких ученых, как Алан Тьюринг, Ирвинг Гуд и Марвин Мински, указывали на философские опасения насчёт того, что сверхинтеллект может захватить контроль.

См. сноски 15-18 в статье Existential risk from artificial intelligence на Википедии, архивная ссылка, получена 21.10.2018.↩

- > Исследователи считают, что существует 50% вероятность того, что ИИ превзойдет человека во всех задачах через 45 лет.

>

> Респондентов спросили, какое влияние ВМИ окажет на человечество в долгосрочной перспективе: положительное или отрицательное. Они оценивали вероятности различных исходов по пятибалльной шкале. Медианными оценками были 25% для "хорошего исхода" и 20% для "чрезвычайно хорошего исхода". В свою очередь, медианная оценка для "плохого" исхода была 10%, и 5% для исхода, сформулированного как "чрезвычайно плохой (например, вымирание человечества)".